Définition de l'entropie : entropie d'information

Equivalent statistique de l'entropie (non démontré)

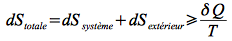

Second principe de la thermodynamique :

D'après le second principe, il y a création d'entropie dans un système isolé :

Entropie et probabilité des états du système

Chaque état macroscopique est un assemblage d'une infinité d'états microscopique, ayant chacun une probabilité spécifique.

Fondamental : définition statistique de l'entropie d'information

Soit une probabilité de distribution P = {p1, p2, ... , pn } des états du système parmi n états, tous indépendants. On peut alors écrire l'entropie d'information selon la formule démontrée par Gibbs : ![]()

Propriétés :

Il y a proportionnalité à une constante près k qui est la constante de Boltzmann kB.

L'entropie S est ≥ 0 ; car la probabilité pj est comprise entre 0 et 1.

S > 0 transformation irréversible

NB : Sj = 0 si pj = 0 (état improbable) ou 1 (totalement probable). transformation réversible

S est une mesure de « l'incertitude » : les états j parfaitement connus ont une entropie nulle Sj = 0 car leur probabilité est nulle pj=0.